Michael Scratch

Registrierter Benutzer

- Zuletzt hier

- 24.04.25

- Registriert

- 29.04.23

- Beiträge

- 1.867

- Kekse

- 12.274

Mischung des Songs „Memento Mori“ im Homerecording

Nachdem ich Euch im ersten Teil meines Workshops Einblicke in die Aufnahme der Instrumente und Vocals zum meinem Song „Memento Mori“ im Homestudio gegeben habe, soll es nun im zweiten Teil um die Postproduktion gehen. Ich spreche über die verwendete Software wie DAW (Digital Audio Workstation), Effekt-Plugins wie Kompressor, EQ, Hall, die Platzierung der Instrumente im Stereo-Panorama, Tonhöhenkorrektur von Bläsern und Gesang.

Die Idee hinter dem "Phil Harmonie Projekt":

Als ich meinen ersten Song „Der Mythos des Sisyphus“ schrieb, suchte ich zunächst einmal nur nach einem passenden Pseudonym, unter dem ich den Song veröffentlichen wollte. Es sollte ein Name sein, der sowohl eine Gruppe von Musikern als auch eine Einzelperson repräsentieren könnte. Denn obwohl ich zu der Zeit noch als Einzelperson komponierte, war mein Wunsch, längerfristig andere Musiker einzubeziehen. Da ich früher als gelernter Mediengestalter Bild / Ton gearbeitet hatte, nahm ich mir Alan Parson zum Vorbild.

Alan Parson war ein genialer Tontechniker, der u.a. bei Pink Floyed "The Dark Side of the Moon" und "Abbey Road" der Beatlers hinter dem Mischpult saß. Er gründete später zusammen mit dem Sänger Eric Woolfson "The Alan Parsons Projekt". Zusammen mit vielen Gastmusikern (z.B. John Miles) veröffentlichte er Alben, die Progressive-Rockgeschichte schrieben, allen voran das 1976 veröffentlichte "Tales of Mystery and imagination".

Da ich mich für Philosophie interessiere und mein erster Song „Der Mythos des Sisyphus“ durch das gleichnamige philosophische Essay Albert Camus inspiriert ist, kam mir der Vorname „Phil“ in den Sinn. Der „Künstler-Nachname“ Harmonie war dann nicht weit.

Der Einsatz klassischer Musikinstrumente war zu diesem frühen Zeitpunkt nicht explizit geplant gewesen. Als ich jedoch anfing, bei „Memento“ Mori mit Gastmusikern zu arbeiten und echte klassischen Musikinstrumente einzubeziehen, kam ich auf den Gedanken, den Namen „Phil Harmonie Projekt“ zum Programm zu machen: So sollen sich die Songs nicht nur mit philosophischen Themen beschäftigen, sondern ich möchte ich auch zukünftig Soli von klassischen Instrumenten spielen lassen. So spielt z.B. in unserem nächsten Song (Spoiler!) „Herz verschenkt“ eine Klarinette – dank dafür an @LoboMix aus dem Forum!

Wenn Du also ein klassisches Instrument spielst und Interesse hast, bei zukünftigen Songs mitzuwirken, dann würde ich mich freuen, wenn Du Dich einfach per PN bei mir meldest.

In der Postproduktion verwendete Soft- und Hardware

Ardour mit folgenden Plugins:

- Fabfilter Pro C Kompressor

- Harrison AVA Vocal Flow

- Harrison C32 Channel (Kompressor / EQ)

- Breverb (Raum-Simulator)

- SIR3 von SIR Audio Tools (Raum-Simulator)

- Harrison XT-MC Multiband Kompressor

- Toontrack EZ Drummer 3 (Schlagzeug)

- Harrison XT-LC Lookahead Compressor

- Native Instruments Kontakt 7 Sampler mit Cremona Quartett

- Fabfilter Pro-Q2 Bandpass EQ

- Sforzando Sample Player mit TinWhistle

Melodyne Essential (Tonhöhenkorrektur)

Davincy Resolve (Videoschnitt und Colorgrading)

Abhöre: Aktive Genelec 1029A mit 1091A aktivem Subwoofer

Kopfhörer: Beyerdynamik DT 770 Pro 32 Ohm

Audio-Interface: Makie Onyx Producer 2-2

Bearbeitung der Vocals sowie der Holz- und Blechbläser mittels Melodyne

Wie ich leider erst nach der Aufnahme feststellen musste, gab es bei Gesang, Holz- und Blechbläsern Probleme mit Intonation.

Die Stimmung von Blasinstrumenten ist nicht wie bei einem Klavier eine feste Größe, die man beim Stimmen einstellen kann. Der Ton der Blechblasinstrumente (Trompete und Posaune) wird durch die Lippenspannung beeinflusst. Bei den Holzblasinstrumenten (Saxophone, Flöten) wird der Ton auch durch die Stärke des des Luftstroms im jeweiligen Moment des Spielens geformt.

Die Probleme bei der Intonation ergaben sich daraus, dass ich bei der Aufnahme der Blechbläser keine gute Abhörkontrolle hatte. Der improvisierte Aufnahmeraum war nicht schallisoliert. Zudem war ich mangels nötigem Equipment dazu verdonnert, die gleichen Kopfhörermischung zu haben, wie die Musiker. Da wir mit Overdub Verfahren arbeiteten, also die meisten Spuren nacheinander einspielten, passierte es, dass die ersten Takes nicht sauber intoniert waren und sich die Musiker bei nachfolgenden Aufnahmen an dieser Stimmung orientierten.

An dieser Stelle kam deshalb in der Postproduktion an dieser Stelle Melodyne Essential zum Einsatz. Mit Melodyne lassen sich Timing und Intonation bearbeiten. Ich exportierte die einzelnen Spuren, die ich bearbeiten wollte in bester Qualität und importierte sie in Melodyne. Melodyne analysiert das Tonmaterial und stellt die Wellenform der einzelnen Töne einer Tonspur isoliert dar. Diese lassen sich nun sehr schnell und einfach korrigieren.

Meine Flöte hatte ich erst vor Weihnachten gekauft. Bei der Aufnahme zu Memento Mori bemerke ich, dass sie nicht die geforderte Stimmung hatte, sondern durchgehend zu tief abgestimmt war. Da ich jedoch nicht warten wollte, bis sie von Thomann umgestauscht und ich die neue Flöte wieder eingespielt hatte, behielt ich die Flötenspuren und bediente mich auch hier Melodyne Essential.

Ebenso wurden die Gesangsspuren mit Melodyne analysiert und gegebenenfalls leicht korrigiert. Die Dynamik des Gesangs wurde mittels Melodyne ebenfalls leicht eingeschränkt (50% Anhebung der leisen Passagen), damit der Kompressor später beim Mixing mit weniger Dynamik zu tun hat.

Ardour

Als DAW verwendete ich sowohl für Aufnahme als auch für die Mischung Ardour. Für Arour habe ich mich aus mehreren Gründen entschieden:

1.) Ardour läuft auf allen drei großen Betriebssystemen (Windows, Linux, Mac). Bis vor kurzem habe ich noch mit Linux produziert und leider ist die Auswahl an professionellen Digital Audio Workstation Software nicht gerade groß. Einzig ernst zu nehmender Mitbewerber scheinen mir unter Linux nur Bitwig Studio und Reaper zu sein. Harrison Mixbus nimmt eine Ausnahmestellung ein, da es auf Ardour basiert.

Der Vorteil einer Software, die sowohl unter Linux als auch auf Windowas und Mac läuft, liegt auf der Hand: Man kann zu einem späteren Zeitpunkt die Plattform wechseln, ohne sich an eine neue Software gewöhnen zu müssen. Kompatible Plugins vorausgesetzt laufen die alten Projekte auch nach einem Betriebssystemwechsel wie gewohnt. Dies ist praktisch, wenn man z.B. vielleicht mal einen Remix alter Aufnahmen machen möchte.

2.) Ardour ist Open Source. Ich bin ein Freund des OpenSource Gedankens, nicht zuletzt deswegen, weil man als Nutzer nicht an einen großen Hersteller gebunden ist und seiner Preis- und Geschäftspolitik ausgeliefert ist. Man kann für die Software soviel zahlen, wie man möchte. Ich spende immer wieder für das Ardour Projekt, da ich die Software regelmäßig nutze.

3.) Es gibt eine sehr hilfsbereite Community. Im englischsprachigen Anwenderforum bekam ich bei Fragen bisher immer hilfreiche Antworten, manchmal sogar von den Entwickeln Paul Davies und Robin Gareus.

4.) Als ich noch beruflich in der Audio-Branche tätig war, arbeitete ich meistens mit ProTools. Zudem habe ich in den 90ern noch mit analogen Mischpulten gearbeitet und bin deshalb mit den Bedienungskonzepten großer analoger Konsolen vertraut. Ardour orientiert sich in Oberfläche und Bedienung an ProTools. ProTools wiederum hat als historisch erste ernst zu nehmende Hard Disc Recording Software die Konzepte der analogen Welt übernommen. Insofern fühlte ich mich in Ardour gleich von Anfang an zuhause.

Wenn man noch einen Schritt weiter gehen möchte, kann man sich für knapp 350 EUR Harrison Mixbus auf den Rechner holen. Auf den analogen Konsolen von Harrison wurden legendäre Alben wie z.B. Michael Jacksons Thriller produziert. Harrisons Mixbus Software baut auf Ardour auf und ist noch in größerem Maße an der Bedienung der alten analogen Pulte angelehnt.

5.) Ardour kann alles, was ich brauche und unterstützt die gängigen Plugin-Formate VST, AU sowie (unter Linux) LADSPA, LV2 und LXVST. Unter Linux lassen sich über WINE und yabridge sogar Windows VST-Plugins einbinden.

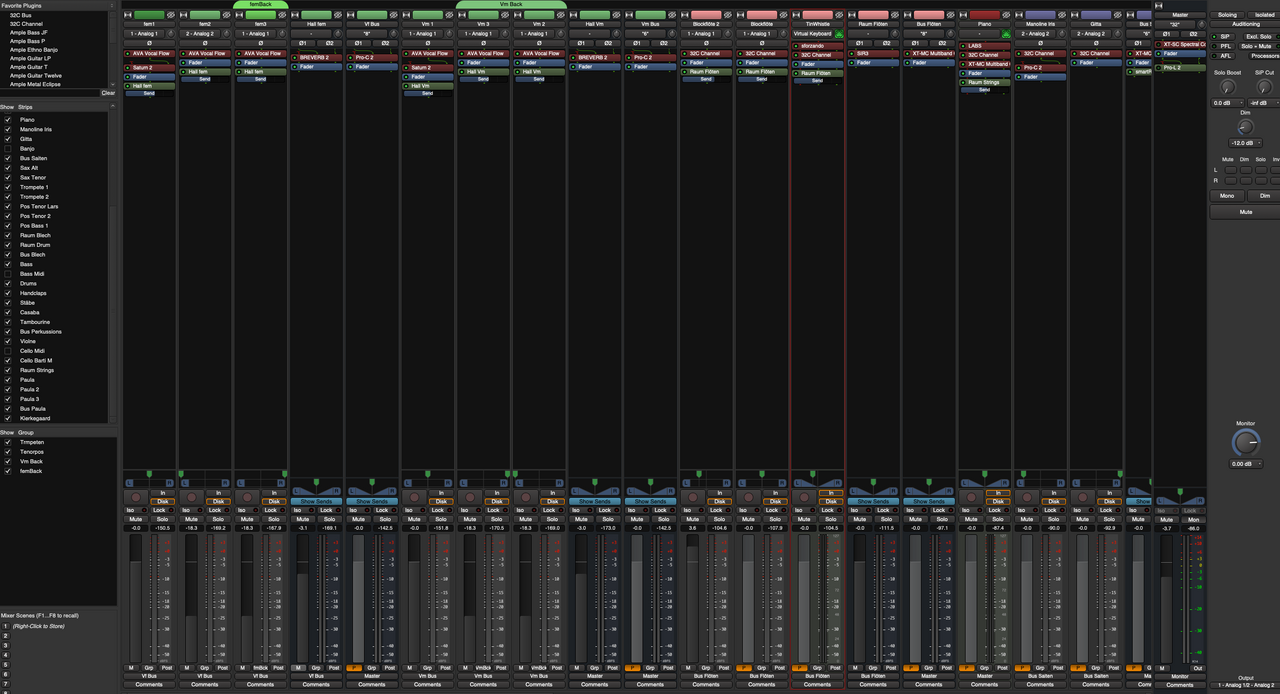

Vorbereitung: Mix Busse

Bevor es ans eigentliche mischen geht, konfiguriere ich mir mein Setup: Ich route mir die Spuren der männlichen Gesangsstimme auf einen Stereobusse. Gleiches mache ich mit den Audiospuren der weiblichen Gesangsstimmen. Auch die Blechbläser (Posaunen, Trompeten) und das Tenor-Saxophon fasse ich auf einem Bus zusammen, ebenso die Percussions (Klatschen, Claves, Cassaba, Tambourine), die Mandoline mit der akustischen Gitarre und die drei Flöten-Spuren.

Das nutzen von Stereobussen hat den Vorteil, dass ich auf diese Weise die zusammengefassten Instrumente mit nur einem Fader im Mix lauter oder leiser machen kann. Ist das Lautstärkeverhältnis der zusammengefassten Instrumente erst einmal eingestellt, muss ich die Fader der Einzelspuren meist nicht mehr anfassen. Dies ließe ich sicherlich auch mit „Mix-Gruppen“ (Groups) realisieren. Die Arbeit mit Bussen hat aber noch weitere Vorteile: Ich kann die Einzelspuren ausblenden und habe so mehr Übersicht geschaffen. Zudem verwende ich oft Kompressoren und EQs sowohl in den Einzelspuren als auch in den Bussen, um auf diese Weise in mehreren Schritten den Dynamikumfang zu reduzieren und eine kompakte Mischung zu bekommen. In den Stereobussen verwende ich dann häufig Multiband-Kompressoren.

Verteilung der Instrumente im Stereobild

Während ich die Instrumente auf Bussen zusammenfasse (oder schon vorher) stelle ich Überlegungen über die Platzierung der Instrumente im Stereobild.

Hier kommen zwei Ebenen ins Spiel:

1.) Das Stereo-Panorama, d.h. die Verteilung der Instrumente auf der Achse zwischen linkem und rechten Lautsprecher. Dies regelt sich beim Mixdown größtenteils über die Panorama- oder (bei Stereio-Spuren) Balance-Regler.

2.) Die Tiefenstaffelung, d.h. Vorne-Hinten-Staffelung. Ob ein Instrument weiter vorne oder weiter hinten wahrgenommen wird, hängt von mehreren Faktoren ab:

- Lautstärke: Je lauter desto näher

- Klangfärbung: Je dumpfer der Klang, desto weiter weg scheint die Signalquelle zu sein. Dies lässt sich leicht an folgendem Beispiel nachvollziehen: Wenn mir jemand ins Ohr flüstert, höre ich mehr Zisch- und ähnliche Laute. Nebenbei bemerkt lässt sich dieser Effekt gut nutzen, indem man Flüsterspuren zu den Gesangsstimmen mischt, die man im Vordergrund haben möchte (dies habe ich z.B. bei meinem Song „Verlorenes Paradies“ an einer Stelle ausprobiert).

- Lautstärke des Hall-Signals: Je mehr Hall-Signal man dem Direkt-Signal beimischt, desto weiter weg erscheint dieses.

- Länge des Pre-Delays des Halles: Wenn sich eine Schallquelle weiter weg von der Wand und nah vorne beim Zuhörer befindet, braucht auch das Hall-Signal, das von der Wand zurück geworfen wird, länger, um beim Zuhörer anzukommen. Hierfür gibt es eine einfache Formel (die ich jetzt nicht herleiten will):

Zeit t (in ms) = 6 * Entfernung in Metern zur Wand (in ms)

Das heißt: Möchte ich ein Instrument, z.B. die Hauptstimme oder das Soloinstrument (im Song „Memento Mori“ das Alt-Saxophon) vorne stehen haben, stelle ich im Hall-Plugin eine längere Predelay-Zeit ein.

Bei „Memento Mori“ habe ich mich bei der Verteilung der Instrumente im Stereobild grob an der amerikanischen Orchesteraufstellung orientiert - ausgenommen der Solo-Stimmen, die ich vorne in die Mitte platzierte).

Dynamik-Bearbeitung

Die Hauptfunktion eines Kompressors besteht darin, den Dynamikumfang eines Audiosignals zu reduzieren. Das bedeutet, er verringert die Differenz zwischen den lautesten und leisesten Teilen einer Aufnahme. Einige spezifische Gründe, warum ein Kompressor verwendet wird:

Wie oben schon erwähnt, komprimiere ich meist in zwei (oder gar drei) Schritten. In dem meisten Kanälen setzte ich das 32C Channel PlugIn von Harrison ein:

In diesem Plugin ist ein einfacher Kompressor mit einem 4-Band EQ und einem Hoch-/Tiefpass-Filter zusammengefasst, so wie man das von gängigen analogen Mischpulten kennt. Die klassischen Instrumente komprimierte ich in den Einzelspuren sehr dezent mit einer Ratio von 2:1 bis maximal 4:1 um ca. 3 bis 12 db.

Für die Gesangsstimmen benutzte ich das Harrison AVA Vocal Flow Plugin. Dieser fasst folgende Komponenten zusammen: 32C Channel EQ, De-Esser, Chorus, Delay, Reverb, Leveler und „Vocal Character“ (2-Band EQ, der sich der Frequenz der gesungenen Tonhöhe anpasst). Für „Memento Mori“ schaltete ich die Delay-, Reverb-, und Deesser-Einheit allerdings ab.

Die Mandoline bearbeitete ich im Kanalzug zunächst mit dem Harrison 32C Channel Plugin und hinterher nochmals mit dem Pro-C 2

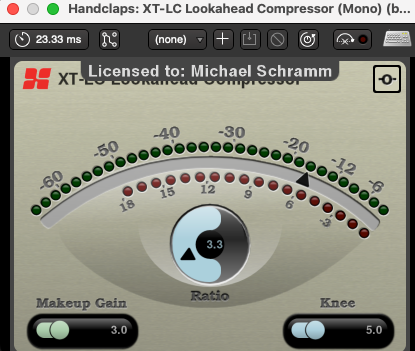

Bei den Percussions schaltete ich im jeweiligen Kanalzug dem 32C Channel Plugin noch einen Harrison XT-LC Lookahead Kompressor davor. Dieser sorgt dafür, dass die schnellen Spitzen der percussiven Signale aufgefangen werden, bevor sie dann im 32C-Kompressor nochmals in der Dynamik reduziert werden.

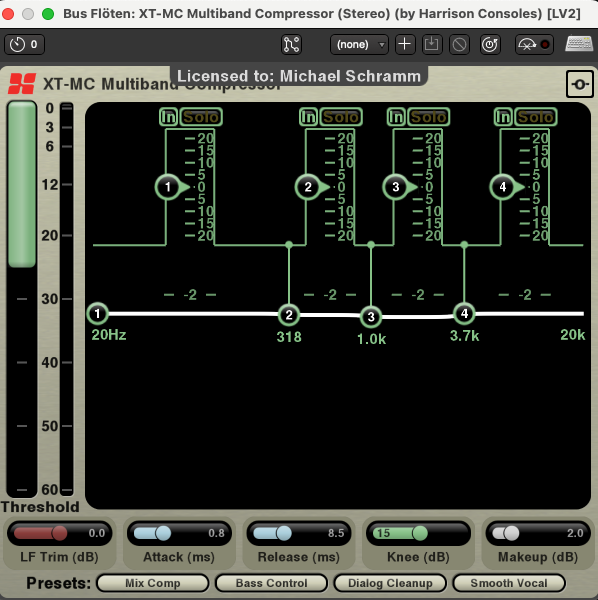

Im zweiten Schritt (oder dritten) Schritt kam dann häufig das XT-MC Multiband Plugin von Harrison in den Bussen zum Einsatz. Dies ist ein 4-Band Kompressor.

In den Vocal-Bussen (männlich / weiblich) kam jeweils ein Fabfilter Pro-C-2 mit der Voreinstellung „Vocal“ zum Einsatz. Während die Harrison Plugins den Signalen eine gewisse „analoge Färbung“ geben, arbeiten die FabFilter Plugins eher „analytisch“.

Bleibt vielleicht noch zu erwähnen, dass Dynamikprozessoren (Kompressoren etc.) und EQs natürlich vor den Lautstärkeregler (Fader) des Kanalzugs gesetzt werden (pre fader). Der Grund liegt auf der Hand: Das Signal soll unabhängig von der Faderstellung bearbeitet werden.

Übrigens: Die Harrison Plugins lassen sich vollumfänglich im Demo Mode verwenden. Es ist nur ein wenig nerfig, weil sie von Zeit zur Zeit eine Aufforderung geben, sie doch bitte zu registrieren.

Raum- / Hall Effekte

In den meisten Fällen setzte ich ein Hall-Plugin nicht direkt in den Kanalzügen oder Bussen ein, sondern beschickte das Effekt-Plugin – ganz klassisch wie in der analogen Welt – über einen Effekt-Send im jeweiligen Kanalzug oder Bus. Dazu füge ich dem virtuellen Mischer zunächst einen neuen Bus hinzu und setze nach dem Fader das gewünschte Hall-Plugin ein (post fader). Auf diese Weise kann ich ein Hall-Plugin aus unterschiedlichen Kanalzügen beschicken. Das Verhältnis des Hall-Anteils der jeweiligen Instrumente wird über die Send-Regler in den Kanalzügen gesteuert. Ziehe ich den Fader eines Kanalzugs hoch, bleibt das Verhältnis zwischen Direkt- und Hall-Signal des Instruments durch die Post-Fader Beschickung gleich. Natürlich muss ich im Hall-Plugin dafür sorgen, dass nur das Effektsignal verwendet wird und die Zumischung des Direkt-Signals im Plugin selbst verhindern.

Für die meisten Instrumente nutzte ich das SIR3 Plugin von SIR Audio Tools. Dies ist ein Faltungshall, der einen echten Raum simuliert. Das Plugin verwendete ich nicht nur einmal, sondern mehrfach mit fast identischer Einstellung. Lediglich die Pre-Delay-Zeit setzte ich individuell unterschiedlich hoch, je nachdem auf welcher Ebene in der Tiefenstaffelung ich das Instrument oder die Instrumentengruppe platziert haben wollte, zwischen 10ms (Schlagzeug), 33ms (Bläser), 41ms (Strings) und 66ms (Flöten).

Die Gesangsstimmen bekamen das BrevVerb 2 mit einem „in the Face“-Hall, d.h. es werden nur die sogenannten ersten Reflexionen (early reflections) genutzt, um Räumlichkeit zu erzeugen; der längere Nachhall eines Raums wird nicht dazu gemischt. Der Nachhall ist für den Eindruck von Räumlichkeit nicht unbedingt nötig und führt häufig dazu, den Mix „matschig“ zu machen, indem er Frequenzen anderer Instrumente verdeckt. Die Pre-Delay-Zeit stellte ich auf 76ms.

Auch das Alt-Saxophon, das aus den Bläsern als Solo-Instrument hervortreten sollte, wurde mit dem BrevReverb anstelle des SIR3 versehen.

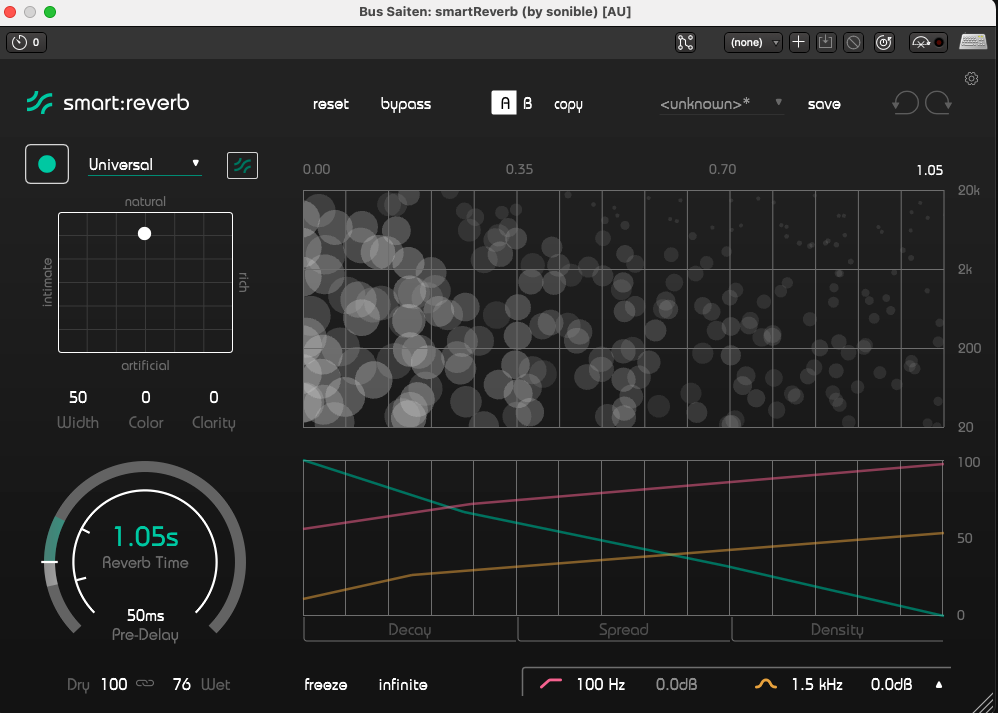

Für Mandoline und akustischer Gitarre nutzte ich das smart:reverb mit einer Reverb Time von 1,05 Sekunden und einem Predelay von 50ms.

EQ-Bearbeitung

Der EQ hat beim Mischen die Aufgabe, Verdeckungs- (Maskierungs-) effekte auszugleichen.

Bei der Einstellung der EQs verfolge ich wenn möglich die Devise: Lieber erst einmal Frequenzen absenken, bevor ich welche angebe.

Vereinfacht gesagt, geht es darum, Frequenzbereiche, die für die Wahrnehmung des Instruments in der Mischung wichtig sind, hervorzuheben und andere Frequenzen abzusenken, damit diese nicht wichtige Frequenzbereiche anderer Instrumente zudecken (maskieren).

Im ersten Schritt stelle ich den Hoch- und Tiefpass Filter ein. Die tiefen Frequenzen sind dem E-Bass vorbehalten. Bei allen anderen Instrumenten senke ich die Tiefen mit dem Hochpassfilter bei 100 bis 300 Hz oder gar 500 Hz ab. Die Einstellung der Grenzfrequenz des Filters ist sehr vom Instrument abhängig.

Die Beurteilung, welche Frequenzen ich mit dem EQ absenke oder anhebe, erfolgt im Zusammenspiel mit den anderen Instrumenten. Die Solo-Funktion dient mir nur zur groben Orientierung. Habe ich im Solo-Modus die untere Grenzfrequenz gefunden, bei der ich eine klar hörbare Veränderung des Klangcharakters des Instruments wahrnehme, schalte ich auf den Gesamtmix um und drehe so lange am virtuellen Poti, bis ich eine Klangveränderung wahrnehme.

Es spielt keine Rolle, ob das Instrument mit EQ „komisch“ und unnatürlich klingt, wenn ich es im Solo-Modus anhöre. Das tut es natürlich, denn es werden Frequenzen angehoben und andere abgesenkt.

Beispiel: Von der akustischen Gitarre und der Mandoline brauche ich, um sie in der Gesamtmischunghörbar zu machen in erster Linie die hohen Anschlag- und Anzupfgeräusche, die zwischen 4 und 6 kHz liegen. Die Sound-“Bäuche“ der tiefen Frequenzen werden ehe von E-Bass und anderen Instrumenten verdeckt und verursachen in der Mischung nur einen „Sound-Brei“, „vermatschen“ mir charakteristische Frequenzen anderer Instrumente.

Die Mischung

Bei der Mischung bin ich meist so vor gegangen, dass ich zunächst einmal das Lautstärkeverhältnis der Instrumente der Instrumentengruppen (Streicher, Blechbläser, Flöten, Stimmen, Schlagzeug, Mandoline und E-Gitarre, E-Gitarren, etc.) untereinander eingestellt habe. Dann machte ich mich an die Mischung der Instrumentengruppen, wobei es dabei natürlich vorkam, dass ich einzelne Instrumente in der Lautstärke etc. noch anpassen musste, weil sie im Gesamtmix von anderen stärker verdeckt wurden als dies beim ausschließlichen Hören der Instrumentengruppe der Fall war.

Obwohl ich meinen alten Linux Laptop gegen einen schnellen Apple Macmini mit M1 Prozessor und 16GB RAM ausgetauscht hatte, kam ich bei der Mischung von „Memento Mori“ mit immerhin 45 Spuren und Bussen mit entsprechend vielen Plugins an die Grenzen der CPU. Manchmal reagierte Ardour oder ein Plugin schon sehr zäh. Was dagegen half: Ardour beenden und neu starten.

In der Stereosumme verwendete ich übrigens nach Rücksprache mit dem Mastering-Ingineer keinen EQ oder Kompressoren. Die Bearbeitung der Stereosumme sollte ausschließlich beim Mastering erfolgen.

Ausblick

Derzeit bin ich bei der Produktion des nächsten Songs „Herz verschenkt“. Dafür habe ich bei der Mischung von „Memento Mori“ viel lernen können. Bei „Herz verschenkt“ gehe ich im Mix noch einen Schritt weiter als bei „Memento Mori“: Ich ziehe die einzelnen Drum-Spuren des Toontrack EZ-Drummer Plugins als Audiospuren auf. Damit habe ich beim Schlagzeug die Möglichkeit, Basedrum, Snare, Hihat, Toms und Overheads gesondert voneinander mit EQ und Kompressoren zu bearbeiten. Vielleicht werde ich noch einen dritten Teil des Workshops schreiben, in dem ich dann über den Videoschnitt mit Davincy Resolve spreche.

Nachdem ich Euch im ersten Teil meines Workshops Einblicke in die Aufnahme der Instrumente und Vocals zum meinem Song „Memento Mori“ im Homestudio gegeben habe, soll es nun im zweiten Teil um die Postproduktion gehen. Ich spreche über die verwendete Software wie DAW (Digital Audio Workstation), Effekt-Plugins wie Kompressor, EQ, Hall, die Platzierung der Instrumente im Stereo-Panorama, Tonhöhenkorrektur von Bläsern und Gesang.

Die Idee hinter dem "Phil Harmonie Projekt":

Als ich meinen ersten Song „Der Mythos des Sisyphus“ schrieb, suchte ich zunächst einmal nur nach einem passenden Pseudonym, unter dem ich den Song veröffentlichen wollte. Es sollte ein Name sein, der sowohl eine Gruppe von Musikern als auch eine Einzelperson repräsentieren könnte. Denn obwohl ich zu der Zeit noch als Einzelperson komponierte, war mein Wunsch, längerfristig andere Musiker einzubeziehen. Da ich früher als gelernter Mediengestalter Bild / Ton gearbeitet hatte, nahm ich mir Alan Parson zum Vorbild.

Alan Parson war ein genialer Tontechniker, der u.a. bei Pink Floyed "The Dark Side of the Moon" und "Abbey Road" der Beatlers hinter dem Mischpult saß. Er gründete später zusammen mit dem Sänger Eric Woolfson "The Alan Parsons Projekt". Zusammen mit vielen Gastmusikern (z.B. John Miles) veröffentlichte er Alben, die Progressive-Rockgeschichte schrieben, allen voran das 1976 veröffentlichte "Tales of Mystery and imagination".

Da ich mich für Philosophie interessiere und mein erster Song „Der Mythos des Sisyphus“ durch das gleichnamige philosophische Essay Albert Camus inspiriert ist, kam mir der Vorname „Phil“ in den Sinn. Der „Künstler-Nachname“ Harmonie war dann nicht weit.

Der Einsatz klassischer Musikinstrumente war zu diesem frühen Zeitpunkt nicht explizit geplant gewesen. Als ich jedoch anfing, bei „Memento“ Mori mit Gastmusikern zu arbeiten und echte klassischen Musikinstrumente einzubeziehen, kam ich auf den Gedanken, den Namen „Phil Harmonie Projekt“ zum Programm zu machen: So sollen sich die Songs nicht nur mit philosophischen Themen beschäftigen, sondern ich möchte ich auch zukünftig Soli von klassischen Instrumenten spielen lassen. So spielt z.B. in unserem nächsten Song (Spoiler!) „Herz verschenkt“ eine Klarinette – dank dafür an @LoboMix aus dem Forum!

Wenn Du also ein klassisches Instrument spielst und Interesse hast, bei zukünftigen Songs mitzuwirken, dann würde ich mich freuen, wenn Du Dich einfach per PN bei mir meldest.

In der Postproduktion verwendete Soft- und Hardware

Ardour mit folgenden Plugins:

- Fabfilter Pro C Kompressor

- Harrison AVA Vocal Flow

- Harrison C32 Channel (Kompressor / EQ)

- Breverb (Raum-Simulator)

- SIR3 von SIR Audio Tools (Raum-Simulator)

- Harrison XT-MC Multiband Kompressor

- Toontrack EZ Drummer 3 (Schlagzeug)

- Harrison XT-LC Lookahead Compressor

- Native Instruments Kontakt 7 Sampler mit Cremona Quartett

- Fabfilter Pro-Q2 Bandpass EQ

- Sforzando Sample Player mit TinWhistle

Melodyne Essential (Tonhöhenkorrektur)

Davincy Resolve (Videoschnitt und Colorgrading)

Abhöre: Aktive Genelec 1029A mit 1091A aktivem Subwoofer

Kopfhörer: Beyerdynamik DT 770 Pro 32 Ohm

Audio-Interface: Makie Onyx Producer 2-2

Bearbeitung der Vocals sowie der Holz- und Blechbläser mittels Melodyne

Wie ich leider erst nach der Aufnahme feststellen musste, gab es bei Gesang, Holz- und Blechbläsern Probleme mit Intonation.

Die Stimmung von Blasinstrumenten ist nicht wie bei einem Klavier eine feste Größe, die man beim Stimmen einstellen kann. Der Ton der Blechblasinstrumente (Trompete und Posaune) wird durch die Lippenspannung beeinflusst. Bei den Holzblasinstrumenten (Saxophone, Flöten) wird der Ton auch durch die Stärke des des Luftstroms im jeweiligen Moment des Spielens geformt.

Die Probleme bei der Intonation ergaben sich daraus, dass ich bei der Aufnahme der Blechbläser keine gute Abhörkontrolle hatte. Der improvisierte Aufnahmeraum war nicht schallisoliert. Zudem war ich mangels nötigem Equipment dazu verdonnert, die gleichen Kopfhörermischung zu haben, wie die Musiker. Da wir mit Overdub Verfahren arbeiteten, also die meisten Spuren nacheinander einspielten, passierte es, dass die ersten Takes nicht sauber intoniert waren und sich die Musiker bei nachfolgenden Aufnahmen an dieser Stimmung orientierten.

An dieser Stelle kam deshalb in der Postproduktion an dieser Stelle Melodyne Essential zum Einsatz. Mit Melodyne lassen sich Timing und Intonation bearbeiten. Ich exportierte die einzelnen Spuren, die ich bearbeiten wollte in bester Qualität und importierte sie in Melodyne. Melodyne analysiert das Tonmaterial und stellt die Wellenform der einzelnen Töne einer Tonspur isoliert dar. Diese lassen sich nun sehr schnell und einfach korrigieren.

Meine Flöte hatte ich erst vor Weihnachten gekauft. Bei der Aufnahme zu Memento Mori bemerke ich, dass sie nicht die geforderte Stimmung hatte, sondern durchgehend zu tief abgestimmt war. Da ich jedoch nicht warten wollte, bis sie von Thomann umgestauscht und ich die neue Flöte wieder eingespielt hatte, behielt ich die Flötenspuren und bediente mich auch hier Melodyne Essential.

Ebenso wurden die Gesangsspuren mit Melodyne analysiert und gegebenenfalls leicht korrigiert. Die Dynamik des Gesangs wurde mittels Melodyne ebenfalls leicht eingeschränkt (50% Anhebung der leisen Passagen), damit der Kompressor später beim Mixing mit weniger Dynamik zu tun hat.

Ardour

Als DAW verwendete ich sowohl für Aufnahme als auch für die Mischung Ardour. Für Arour habe ich mich aus mehreren Gründen entschieden:

1.) Ardour läuft auf allen drei großen Betriebssystemen (Windows, Linux, Mac). Bis vor kurzem habe ich noch mit Linux produziert und leider ist die Auswahl an professionellen Digital Audio Workstation Software nicht gerade groß. Einzig ernst zu nehmender Mitbewerber scheinen mir unter Linux nur Bitwig Studio und Reaper zu sein. Harrison Mixbus nimmt eine Ausnahmestellung ein, da es auf Ardour basiert.

Der Vorteil einer Software, die sowohl unter Linux als auch auf Windowas und Mac läuft, liegt auf der Hand: Man kann zu einem späteren Zeitpunkt die Plattform wechseln, ohne sich an eine neue Software gewöhnen zu müssen. Kompatible Plugins vorausgesetzt laufen die alten Projekte auch nach einem Betriebssystemwechsel wie gewohnt. Dies ist praktisch, wenn man z.B. vielleicht mal einen Remix alter Aufnahmen machen möchte.

2.) Ardour ist Open Source. Ich bin ein Freund des OpenSource Gedankens, nicht zuletzt deswegen, weil man als Nutzer nicht an einen großen Hersteller gebunden ist und seiner Preis- und Geschäftspolitik ausgeliefert ist. Man kann für die Software soviel zahlen, wie man möchte. Ich spende immer wieder für das Ardour Projekt, da ich die Software regelmäßig nutze.

3.) Es gibt eine sehr hilfsbereite Community. Im englischsprachigen Anwenderforum bekam ich bei Fragen bisher immer hilfreiche Antworten, manchmal sogar von den Entwickeln Paul Davies und Robin Gareus.

4.) Als ich noch beruflich in der Audio-Branche tätig war, arbeitete ich meistens mit ProTools. Zudem habe ich in den 90ern noch mit analogen Mischpulten gearbeitet und bin deshalb mit den Bedienungskonzepten großer analoger Konsolen vertraut. Ardour orientiert sich in Oberfläche und Bedienung an ProTools. ProTools wiederum hat als historisch erste ernst zu nehmende Hard Disc Recording Software die Konzepte der analogen Welt übernommen. Insofern fühlte ich mich in Ardour gleich von Anfang an zuhause.

Wenn man noch einen Schritt weiter gehen möchte, kann man sich für knapp 350 EUR Harrison Mixbus auf den Rechner holen. Auf den analogen Konsolen von Harrison wurden legendäre Alben wie z.B. Michael Jacksons Thriller produziert. Harrisons Mixbus Software baut auf Ardour auf und ist noch in größerem Maße an der Bedienung der alten analogen Pulte angelehnt.

5.) Ardour kann alles, was ich brauche und unterstützt die gängigen Plugin-Formate VST, AU sowie (unter Linux) LADSPA, LV2 und LXVST. Unter Linux lassen sich über WINE und yabridge sogar Windows VST-Plugins einbinden.

Vorbereitung: Mix Busse

Bevor es ans eigentliche mischen geht, konfiguriere ich mir mein Setup: Ich route mir die Spuren der männlichen Gesangsstimme auf einen Stereobusse. Gleiches mache ich mit den Audiospuren der weiblichen Gesangsstimmen. Auch die Blechbläser (Posaunen, Trompeten) und das Tenor-Saxophon fasse ich auf einem Bus zusammen, ebenso die Percussions (Klatschen, Claves, Cassaba, Tambourine), die Mandoline mit der akustischen Gitarre und die drei Flöten-Spuren.

Das nutzen von Stereobussen hat den Vorteil, dass ich auf diese Weise die zusammengefassten Instrumente mit nur einem Fader im Mix lauter oder leiser machen kann. Ist das Lautstärkeverhältnis der zusammengefassten Instrumente erst einmal eingestellt, muss ich die Fader der Einzelspuren meist nicht mehr anfassen. Dies ließe ich sicherlich auch mit „Mix-Gruppen“ (Groups) realisieren. Die Arbeit mit Bussen hat aber noch weitere Vorteile: Ich kann die Einzelspuren ausblenden und habe so mehr Übersicht geschaffen. Zudem verwende ich oft Kompressoren und EQs sowohl in den Einzelspuren als auch in den Bussen, um auf diese Weise in mehreren Schritten den Dynamikumfang zu reduzieren und eine kompakte Mischung zu bekommen. In den Stereobussen verwende ich dann häufig Multiband-Kompressoren.

Verteilung der Instrumente im Stereobild

Während ich die Instrumente auf Bussen zusammenfasse (oder schon vorher) stelle ich Überlegungen über die Platzierung der Instrumente im Stereobild.

Hier kommen zwei Ebenen ins Spiel:

1.) Das Stereo-Panorama, d.h. die Verteilung der Instrumente auf der Achse zwischen linkem und rechten Lautsprecher. Dies regelt sich beim Mixdown größtenteils über die Panorama- oder (bei Stereio-Spuren) Balance-Regler.

2.) Die Tiefenstaffelung, d.h. Vorne-Hinten-Staffelung. Ob ein Instrument weiter vorne oder weiter hinten wahrgenommen wird, hängt von mehreren Faktoren ab:

- Lautstärke: Je lauter desto näher

- Klangfärbung: Je dumpfer der Klang, desto weiter weg scheint die Signalquelle zu sein. Dies lässt sich leicht an folgendem Beispiel nachvollziehen: Wenn mir jemand ins Ohr flüstert, höre ich mehr Zisch- und ähnliche Laute. Nebenbei bemerkt lässt sich dieser Effekt gut nutzen, indem man Flüsterspuren zu den Gesangsstimmen mischt, die man im Vordergrund haben möchte (dies habe ich z.B. bei meinem Song „Verlorenes Paradies“ an einer Stelle ausprobiert).

- Lautstärke des Hall-Signals: Je mehr Hall-Signal man dem Direkt-Signal beimischt, desto weiter weg erscheint dieses.

- Länge des Pre-Delays des Halles: Wenn sich eine Schallquelle weiter weg von der Wand und nah vorne beim Zuhörer befindet, braucht auch das Hall-Signal, das von der Wand zurück geworfen wird, länger, um beim Zuhörer anzukommen. Hierfür gibt es eine einfache Formel (die ich jetzt nicht herleiten will):

Zeit t (in ms) = 6 * Entfernung in Metern zur Wand (in ms)

Das heißt: Möchte ich ein Instrument, z.B. die Hauptstimme oder das Soloinstrument (im Song „Memento Mori“ das Alt-Saxophon) vorne stehen haben, stelle ich im Hall-Plugin eine längere Predelay-Zeit ein.

Bei „Memento Mori“ habe ich mich bei der Verteilung der Instrumente im Stereobild grob an der amerikanischen Orchesteraufstellung orientiert - ausgenommen der Solo-Stimmen, die ich vorne in die Mitte platzierte).

Dynamik-Bearbeitung

Die Hauptfunktion eines Kompressors besteht darin, den Dynamikumfang eines Audiosignals zu reduzieren. Das bedeutet, er verringert die Differenz zwischen den lautesten und leisesten Teilen einer Aufnahme. Einige spezifische Gründe, warum ein Kompressor verwendet wird:

- Lautstärkekontrolle: Ein Kompressor kann dazu beitragen, die Lautstärkepegel konstant zu halten. Zum Beispiel kann er verhindern, dass bestimmte Passagen einer Gesangsspur zu laut werden und andere zu leise im Mix liegen. Dadurch wird eine gleichmäßigere Lautstärke über den gesamten Track erreicht.

- Verstärkung von leisen Passagen: Neben der Reduzierung der Lautstärke von Spitzen kann ein Kompressor auch dazu verwendet werden, leisere Passagen anzuheben. Das macht Details in einer Aufnahme hörbarer und verbessert die Klarheit und Präsenz des Audiomaterials.

- Soundformung: Kompressoren können auch kreativ eingesetzt werden, um den Charakter eines Sounds zu formen. Durch die Einstellung der Attack- und Release-Zeiten kann ein Kompressor einem Instrument mehr Punch verleihen oder dazu beitragen, es im Mix weicher klingen zu lassen.

- Vermeidung von Übersteuerungen: Indem der Dynamikumfang reduziert wird, hilft ein Kompressor auch dabei, Übersteuerungen im Signalweg zu vermeiden, besonders wenn das Signal später verstärkt wird.

Wie oben schon erwähnt, komprimiere ich meist in zwei (oder gar drei) Schritten. In dem meisten Kanälen setzte ich das 32C Channel PlugIn von Harrison ein:

In diesem Plugin ist ein einfacher Kompressor mit einem 4-Band EQ und einem Hoch-/Tiefpass-Filter zusammengefasst, so wie man das von gängigen analogen Mischpulten kennt. Die klassischen Instrumente komprimierte ich in den Einzelspuren sehr dezent mit einer Ratio von 2:1 bis maximal 4:1 um ca. 3 bis 12 db.

Für die Gesangsstimmen benutzte ich das Harrison AVA Vocal Flow Plugin. Dieser fasst folgende Komponenten zusammen: 32C Channel EQ, De-Esser, Chorus, Delay, Reverb, Leveler und „Vocal Character“ (2-Band EQ, der sich der Frequenz der gesungenen Tonhöhe anpasst). Für „Memento Mori“ schaltete ich die Delay-, Reverb-, und Deesser-Einheit allerdings ab.

Die Mandoline bearbeitete ich im Kanalzug zunächst mit dem Harrison 32C Channel Plugin und hinterher nochmals mit dem Pro-C 2

Bei den Percussions schaltete ich im jeweiligen Kanalzug dem 32C Channel Plugin noch einen Harrison XT-LC Lookahead Kompressor davor. Dieser sorgt dafür, dass die schnellen Spitzen der percussiven Signale aufgefangen werden, bevor sie dann im 32C-Kompressor nochmals in der Dynamik reduziert werden.

Im zweiten Schritt (oder dritten) Schritt kam dann häufig das XT-MC Multiband Plugin von Harrison in den Bussen zum Einsatz. Dies ist ein 4-Band Kompressor.

In den Vocal-Bussen (männlich / weiblich) kam jeweils ein Fabfilter Pro-C-2 mit der Voreinstellung „Vocal“ zum Einsatz. Während die Harrison Plugins den Signalen eine gewisse „analoge Färbung“ geben, arbeiten die FabFilter Plugins eher „analytisch“.

Bleibt vielleicht noch zu erwähnen, dass Dynamikprozessoren (Kompressoren etc.) und EQs natürlich vor den Lautstärkeregler (Fader) des Kanalzugs gesetzt werden (pre fader). Der Grund liegt auf der Hand: Das Signal soll unabhängig von der Faderstellung bearbeitet werden.

Übrigens: Die Harrison Plugins lassen sich vollumfänglich im Demo Mode verwenden. Es ist nur ein wenig nerfig, weil sie von Zeit zur Zeit eine Aufforderung geben, sie doch bitte zu registrieren.

Raum- / Hall Effekte

In den meisten Fällen setzte ich ein Hall-Plugin nicht direkt in den Kanalzügen oder Bussen ein, sondern beschickte das Effekt-Plugin – ganz klassisch wie in der analogen Welt – über einen Effekt-Send im jeweiligen Kanalzug oder Bus. Dazu füge ich dem virtuellen Mischer zunächst einen neuen Bus hinzu und setze nach dem Fader das gewünschte Hall-Plugin ein (post fader). Auf diese Weise kann ich ein Hall-Plugin aus unterschiedlichen Kanalzügen beschicken. Das Verhältnis des Hall-Anteils der jeweiligen Instrumente wird über die Send-Regler in den Kanalzügen gesteuert. Ziehe ich den Fader eines Kanalzugs hoch, bleibt das Verhältnis zwischen Direkt- und Hall-Signal des Instruments durch die Post-Fader Beschickung gleich. Natürlich muss ich im Hall-Plugin dafür sorgen, dass nur das Effektsignal verwendet wird und die Zumischung des Direkt-Signals im Plugin selbst verhindern.

Für die meisten Instrumente nutzte ich das SIR3 Plugin von SIR Audio Tools. Dies ist ein Faltungshall, der einen echten Raum simuliert. Das Plugin verwendete ich nicht nur einmal, sondern mehrfach mit fast identischer Einstellung. Lediglich die Pre-Delay-Zeit setzte ich individuell unterschiedlich hoch, je nachdem auf welcher Ebene in der Tiefenstaffelung ich das Instrument oder die Instrumentengruppe platziert haben wollte, zwischen 10ms (Schlagzeug), 33ms (Bläser), 41ms (Strings) und 66ms (Flöten).

Die Gesangsstimmen bekamen das BrevVerb 2 mit einem „in the Face“-Hall, d.h. es werden nur die sogenannten ersten Reflexionen (early reflections) genutzt, um Räumlichkeit zu erzeugen; der längere Nachhall eines Raums wird nicht dazu gemischt. Der Nachhall ist für den Eindruck von Räumlichkeit nicht unbedingt nötig und führt häufig dazu, den Mix „matschig“ zu machen, indem er Frequenzen anderer Instrumente verdeckt. Die Pre-Delay-Zeit stellte ich auf 76ms.

Auch das Alt-Saxophon, das aus den Bläsern als Solo-Instrument hervortreten sollte, wurde mit dem BrevReverb anstelle des SIR3 versehen.

Für Mandoline und akustischer Gitarre nutzte ich das smart:reverb mit einer Reverb Time von 1,05 Sekunden und einem Predelay von 50ms.

EQ-Bearbeitung

Der EQ hat beim Mischen die Aufgabe, Verdeckungs- (Maskierungs-) effekte auszugleichen.

Bei der Einstellung der EQs verfolge ich wenn möglich die Devise: Lieber erst einmal Frequenzen absenken, bevor ich welche angebe.

Vereinfacht gesagt, geht es darum, Frequenzbereiche, die für die Wahrnehmung des Instruments in der Mischung wichtig sind, hervorzuheben und andere Frequenzen abzusenken, damit diese nicht wichtige Frequenzbereiche anderer Instrumente zudecken (maskieren).

Im ersten Schritt stelle ich den Hoch- und Tiefpass Filter ein. Die tiefen Frequenzen sind dem E-Bass vorbehalten. Bei allen anderen Instrumenten senke ich die Tiefen mit dem Hochpassfilter bei 100 bis 300 Hz oder gar 500 Hz ab. Die Einstellung der Grenzfrequenz des Filters ist sehr vom Instrument abhängig.

Die Beurteilung, welche Frequenzen ich mit dem EQ absenke oder anhebe, erfolgt im Zusammenspiel mit den anderen Instrumenten. Die Solo-Funktion dient mir nur zur groben Orientierung. Habe ich im Solo-Modus die untere Grenzfrequenz gefunden, bei der ich eine klar hörbare Veränderung des Klangcharakters des Instruments wahrnehme, schalte ich auf den Gesamtmix um und drehe so lange am virtuellen Poti, bis ich eine Klangveränderung wahrnehme.

Es spielt keine Rolle, ob das Instrument mit EQ „komisch“ und unnatürlich klingt, wenn ich es im Solo-Modus anhöre. Das tut es natürlich, denn es werden Frequenzen angehoben und andere abgesenkt.

Beispiel: Von der akustischen Gitarre und der Mandoline brauche ich, um sie in der Gesamtmischunghörbar zu machen in erster Linie die hohen Anschlag- und Anzupfgeräusche, die zwischen 4 und 6 kHz liegen. Die Sound-“Bäuche“ der tiefen Frequenzen werden ehe von E-Bass und anderen Instrumenten verdeckt und verursachen in der Mischung nur einen „Sound-Brei“, „vermatschen“ mir charakteristische Frequenzen anderer Instrumente.

Die Mischung

Bei der Mischung bin ich meist so vor gegangen, dass ich zunächst einmal das Lautstärkeverhältnis der Instrumente der Instrumentengruppen (Streicher, Blechbläser, Flöten, Stimmen, Schlagzeug, Mandoline und E-Gitarre, E-Gitarren, etc.) untereinander eingestellt habe. Dann machte ich mich an die Mischung der Instrumentengruppen, wobei es dabei natürlich vorkam, dass ich einzelne Instrumente in der Lautstärke etc. noch anpassen musste, weil sie im Gesamtmix von anderen stärker verdeckt wurden als dies beim ausschließlichen Hören der Instrumentengruppe der Fall war.

Obwohl ich meinen alten Linux Laptop gegen einen schnellen Apple Macmini mit M1 Prozessor und 16GB RAM ausgetauscht hatte, kam ich bei der Mischung von „Memento Mori“ mit immerhin 45 Spuren und Bussen mit entsprechend vielen Plugins an die Grenzen der CPU. Manchmal reagierte Ardour oder ein Plugin schon sehr zäh. Was dagegen half: Ardour beenden und neu starten.

In der Stereosumme verwendete ich übrigens nach Rücksprache mit dem Mastering-Ingineer keinen EQ oder Kompressoren. Die Bearbeitung der Stereosumme sollte ausschließlich beim Mastering erfolgen.

Ausblick

Derzeit bin ich bei der Produktion des nächsten Songs „Herz verschenkt“. Dafür habe ich bei der Mischung von „Memento Mori“ viel lernen können. Bei „Herz verschenkt“ gehe ich im Mix noch einen Schritt weiter als bei „Memento Mori“: Ich ziehe die einzelnen Drum-Spuren des Toontrack EZ-Drummer Plugins als Audiospuren auf. Damit habe ich beim Schlagzeug die Möglichkeit, Basedrum, Snare, Hihat, Toms und Overheads gesondert voneinander mit EQ und Kompressoren zu bearbeiten. Vielleicht werde ich noch einen dritten Teil des Workshops schreiben, in dem ich dann über den Videoschnitt mit Davincy Resolve spreche.

Zuletzt bearbeitet: